Nvidiaは2023年11月13日、現在のジェネレーティブAI革命を牽引する高度な人工知能モデルの訓練と展開に特化した最先端のグラフィックス・プロセッシング・ユニット(GPU)であるH200を発表した。この新しいGPUは、OpenAIが最も洗練された言語モデルGPT-4のトレーニングに使用した前モデルH100からのアップグレードを意味する。このチップの供給には限りがあるため、大手企業、新興企業、政府機関の間で激しい競争が起きている。

レイモンド・ジェームズの試算によると、H100チップのコストは2万5000~4万ドルで、最大規模のモデルの学習を容易にするためには、これらのチップを相当数組み合わせなければならない。"トレーニング "として知られるプロセスだ。エヌビディアのAI GPUが市場に与えるインパクトは、同社の株価を目覚ましく急騰させ、2023年までに230%以上増加させた。エヌビディアは第3四半期に約160億ドルの売上を見込んでおり、これは前年比170%増という驚異的な伸びを反映している。H200は、141GBの最先端「HBM3」メモリーを搭載し、「推論」時のチップ性能を強化するという重要な進歩を遂げた。推論は、テキスト、画像、または予測を生成するために訓練されたモデルを展開することを含む。

Nvidiaは、H200は、MetaのLlama 2 LLMを使用したテストによって証明されたように、その前身であるH100の約2倍の速さで出力を生成できると主張している。2024年の第2四半期にリリースされる予定のH200は、AMDのMI300X GPUに対抗するもので、同じような特性を持ち、推論用の大規模モデルに対応するために強化されたメモリー機能を誇る。

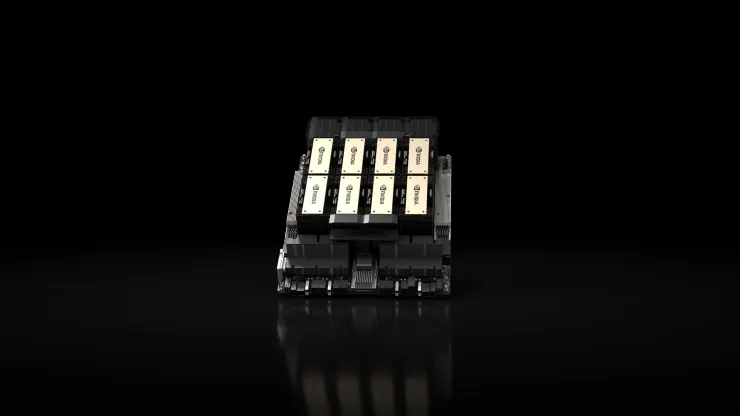

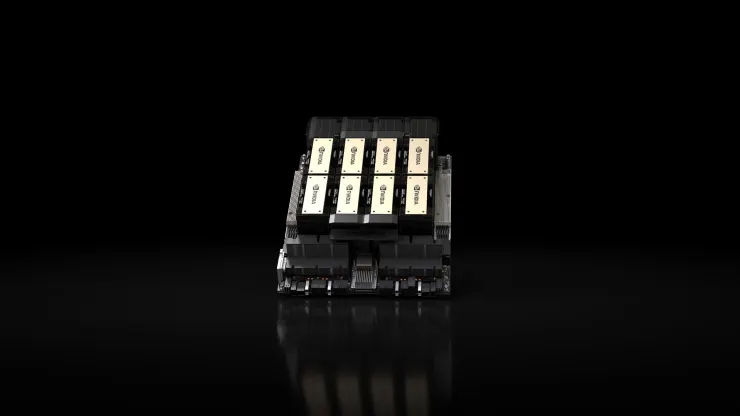

H200の特筆すべき利点は、H100との互換性にあり、現在旧モデルを採用しているAI企業は、サーバーシステムやソフトウェアを変更することなく、新バージョンをシームレスに統合することができる。H200は、NvidiaのHGXコンプリート・システムを通じて4GPUまたは8GPUのサーバー構成に組み込むことができ、H200 GPUとArmベースのプロセッサーを組み合わせたGH200として知られるチップもある。しかし、H200がNvidiaの最速AIチップとして君臨するのは一時的なものかもしれない。

Nvidiaはさまざまなチップ構成を提供しているが、メーカーが新しいアーキテクチャを採用する際には、通常2年ごとに大幅な進化が起こり、単なるメモリの増加やその他の小規模な最適化を超える大幅な性能向上が実現する。H100とH200はどちらも、NvidiaのHopperアーキテクチャをベースにしている。10月、Nvidiaは投資家に対し、同社のGPUに対する需要の高さから、2年ごとのアーキテクチャ・ケーデンスではなく、1年ごとのリリース・パターンに移行することを示唆した。同社は、2024年にBlackwellアーキテクチャに基づくB100チップを発表・リリースすることを示唆するスライドを公開した。